Un modèle simple du réchauffement climatique.

I- Problématique et objectifs de ce travail

Comme le montre clairement le graphique suivant issu de la NASA, on observe depuis quelques décennies une augmentation de la Température Moyenne Annuelle Mondiale (TMAM).

La grosse majorité des scientifiques qui travaillent sur la question identifient l'origine principale de ce phénomène de réchauffement climatique comme étant l'émission des gaz à effet de serre (GES), notamment le dioxyde de carbone (CO₂), provoquée par l'activité humaine depuis le début de la période industrielle.

Ce phénomène étant déjà loin d'être neutre et, s'il s'accentue encore, pouvant avoir des conséquences négatives et même catastrophiques pour la planète et ses occupants, la communauté internationale a confié à des équipes de chercheurs du monde entier la mise au point de modèles sophistiqués climatiques. En prenant en compte un maximum de données physiques et climatiques, ceux-ci sont censés permettre de prévoir les évolutions futures concernant les températures, les précipitations, les zones de glace, les niveaux des océans, etc..., bref tout ce qui sert à définir et à préciser le climat mondial et ses évolutions. Pour cela, ces équipes programment leurs modèles sur des calculateurs très puissants, capables de brasser des milliers d'informations en un temps infime, et ils peuvent ainsi reconstituer en quelques dizaines d'heures ou quelques journées, l'évolution climatique mondiale sur plusieurs décennies. Cela tout en se plaçant dans diverses hypothèses, notamment concernant l'évolution future des émissions de GES.

Mais comme l'écrivait en 2010 le scientifique et philosophe Henri ATLAN dans le journal français Le Monde:

«Il y a un problème de crédibilité des modèles de changements climatiques et des prédictions qui en sont déduites. Ces modèles concernent en effet un domaine - le climat - où le nombre de données disponibles est petit par rapport au nombre de variables qui sont prises en compte dans leur construction, sans parler des variables encore inconnues. Cela implique qu'il existe un grand nombre de bons modèles, capables de rendre compte des observations disponibles, alors même qu'ils reposent sur des hypothèses explicatives différentes et conduisent aussi à des prédictions différentes, voire opposées. Il s'agit là d'une situation dite "des modèles par les observations", cas particulier de "sous-détermination des théories par les faits", bien connue des chercheurs engagés dans la construction de modèles de systèmes complexes naturels, où le nombre de données ne peut pas être multiplié à l'envi par des expérimentations répétées et reproductibles. Conséquence : les modèles sur les changements climatiques ne peuvent être que des hypothèses, mises en formes informatiques très sophistiquées mais pleines d'incertitudes quant à leur relation à la réalité ; et il en va de même de prédictions qui en sont déduites.«» (https://www.lemonde.fr/idees/article/2010/03/27/la-religion-de-la-catastrophe-par-henri-atlan_1325086_3232.html).

De fait, ces différents modèles arrivent à des différences de résultats de plusieurs °C de l'un à l'autre.

Voilà en effet les différentes prévisions données sous les mêmes hypothèses d'émissions de GES par huit modèles analysés par le Groupe d'experts intergouvernemental sur l'évolution du climats (GIEC) dans son dernier rapport:

Nous remarquons effectivement une grosse amplitude de près de 3°C dans les différents résultats de température donnés par ces huit modèles pour l'an 2100.

Nous remarquons effectivement une grosse amplitude de près de 3°C dans les différents résultats de température donnés par ces huit modèles pour l'an 2100.

L'une des principales causes de ces différences est la puissance des hyper-calculateurs utilisés, encore très loin de pouvoir numériser sur un maillage suffisamment petit pour que par exemple soit bien rendue l'influence des nuages bas. Chaque équipe conceptrice d'un tel modèle doit donc paramétrer assez arbitrairement cette influence à l'intérieur de ses programmes numériques, ce qui explique en grande partie les différences importantes de résultats d'un modèle à l'autre. Car, comme le reconnaissent les climatologues, les nuages bas ont une grosse influence rétro-active sur la TMAM, d'ailleurs elle-même encore sujette à débats concernant son influence positive ou négative sur la température à la surface.

Donc d'importantes différences de paramétrage et de résultats d'un modèle à l'autre même s'ils sont validés en partie par leur adéquation avec les résultats des périodes connues, après y avoir intégré des conséquences d'évènements qu'ils ne peuvent prévoir, comme par exemple les éruptions volcaniques.

Compte-tenu de cela, nous avons pris délibérément dans ce travail une toute autre option:

∙ Non faire un modèle sophistiqué, fondé sur les lois physiques, prenant en compte avec le plus de finesse possible un maximum de paramètres et donnant des prévisions sur la plupart des événements liés au climat: fonte des glaces, courants océaniques, couplage air-océans, fréquences des événements exceptionnels comme les canicules et les ouragans, etc...

Comme nous venons de l'expliquer, cette démarche est, à notre avis du moins dans l'état actuel de la technologie et des sciences, vouée à une grosse part d'incertitudes quant à ses résultats.

∙ Mais faire un modèle le plus simple possible orienté sur un seul objectif : pouvoir prédire fiablement la température mondiale moyenne pour les décennies à venir.

Pour obtenir ces prévisions, notre modèle ne prendra directement en compte qu'un minimum de paramètres, ceux que nous analyserons comme ayant une influence directe et importante sur la TMAM.

A savoir:

1- D'abord l'évolution de la concentration en GES dans l'atmosphère. Contrairement aux "climato-sceptiques", nous ne contestons pas son influence primordiale et directe dans le réchauffement climatique actuel.

2- Nous y rajoutons l'interaction nuages bas- températures que nous analyserons par la suite comme un phénomène "prédateurs- proies" à effet rétro-actif négatif important sur la TMAM.

Tout le reste sera pris en compte de manière globale en se fondant sur la réalité observée et moyennisée de l'évolution de la TMAM sur les cinquante dernières années, donc depuis environ 1970:

Le choix de cette période est principalement justifié par les deux raisons suivantes:

1 - La plupart des climatologues et le GIEC lui-même considèrent que c'est à partir de 1970 que l'influence de l'augmentation de la concentration de CO₂ dans l'atmosphère commence à vraiment se faire sentir sur la TMAM.

2 ∙ Cette période est suffisamment longue pour moyenniser convenablement les fluctuations provoquées par les cycles solaires (d'une durée d'environ 11 ans) et océaniques (suite aux courants, l'eau en surface des océans est renouvelée environ tous les 50 ans), ainsi que celles causées par des événements plus aléatoires comme les éruptions volcaniques ou El Nino.

Compte tenu de tout cela, notre modèle sera discret (et non continu comme ceux évalués par le GIEC).

L'unité de temps de ce modèle discret sera bien sûr l'année, puisque cette unité est evidemment la plus adéquate pour moyenniser les écarts de température dûs aux différentes saisons annuelles et que notre seul objectif est de prévoir la TMAM.

Nous concevons que cette méthode puisse paraître à certains bien trop rudimentaire pour espérer pouvoir donner des résultats fiables. C'est pour quoi nous allons consacrer le petit paragraphe suivant pour en justifier le bien-fondé.

II- Bien-fondé de la méthode choisie

Tout d'abord une argumentation pratique:

Imaginons une habitation mal isolée, sujette à courants d'air, avec des ouvertures vitrées laissant passer plus ou moins bien les rayons solaires, ayant des radiateurs de puissances variées pour chauffer l'hiver et des ventilateurs plus ou moins efficaces pour rafraichir l'été, etc.... Les habitants de cette maison sont plus ou moins frileux, et craignent plus ou moins la chaleur estivale: certains dorment la fenêtre ouverte pendant que d'autres ne supportent pas la fraicheur extérieure des nuits.

Cette habitation est mise en vente.

Que fera son futur propriétaire s'il veut prévoir les températures annuelles moyennes, minimales et maximales de cette maison pour un budget d'energie donné?

- Une modélisation sophistiquée prenant en compte le maximum de paramètres, les flux de courants d'air, la pénétration des UV et la dissipation des infra-rouges, la convexion des radiateurs, les ouvertures sporadiques des fenêtres, le caractère plus ou moins frileux de ses futurs habitants, etc ?

- Ou il demandera à un expert de lui faire un bilan lui permettant de classer sa future maison sur le plan energétique et d'en déduire ensuite le budget de chauffage et d'electricité à prévoir, années après années, et les éventuels travaux d'isolation à faire en urgence?

Même si c'est un climatologue travaillant pour le GIEC, il choisira bien sûr la seconde méthode.

Concernant l'obtention de la prévision des TMAM futures de la Terre, nous faisons un peu le même choix:

- Non pas, comme le font les climatologues du GIEC tenter de mettre au point un modèle capable d'intégrer le maximum de données climatiques.

- Mais partir d'une expertise solide fondée sur les réalités observées les années précédentes, pour projeter ces résultats moyens sur les années suivantes en y intégrant des évolutions éventuelles.

Donnons maintenant une argumentation plus théorique:

Les phénomènes climatiques sont chaotiques, c'est même par l'intermédiaire de la climatologie qu'est apparue la théorie mathématique du chaos. Cf. le célèbre "effet papillon" exprimé pour la première fois par le climatologue Edward Lorenz en 1972.

Il y a donc dans la plupart de ces phénomènes une forte non-linéarité: de très légères modifications des conditions initiales peuvent avoir à terme des conséquences très différentes.

Donc sur le plan purement théorique, bâtir les modèles sur des données ponctuelles et très fines ne peut que soulever de grosses questions sur la qualité et la fiabilité des prévisions obtenues pour quelques dizaines d'années plus tard.

Par contre, partir de résultats moyennisés sur 50 ans, cela neutralise en grande partie cette non-linéarité et permet même d'aboutir à une certaine linéarité pour l'obtention des résultats pour 10, 20 ou même 100 ans après.

Pour comprendre la différence fondamentale qu'il y a entre ces deux approches, on peut faire référence au mouvement des particules: complétement imprévisible sur le plan local (mouvement brownien), par contre quand il est moyennisé sur une grosse quantité, parfaitement maitrisable: alors qu'on ne peut pas prévoir grand chose sur une seule de ces particules, si on apporte telle quantité d'énergie à tel gros volume de ces particules, on peut très bien prévoir la nouvelle température moyenne qu'il atteindra et qui traduit justement leur mouvement moyen.

En conclusion de ce paragraphe: le choix de notre méthode par rapport à celui fait par les climatologues du GIEC offre les deux énormes avantages suivants:

1- C'est de très loin le plus pratique et le plus facile à mettre en oeuvre.

2- C'est indéniablement, sur le plan purement théorique, le plus judicieux.

Pourquoi les climatologues ont-ils pourtant fait systématiquement l'autre choix?

Peut-être parce qu'ils sont tous d'éminents climatologues et qu'à ce titre ils affectionnent de mettre en oeuvre leurs connaissances les plus pointues. C'est le syndrome classique de l'expert. Syndrome qui peut les aveugler complétement pour voir qu'une approche bien plus modeste peut conduire à des résultats nettement plus faciles à obtenir et en même temps certainement plus fiables.

Peut-être aussi parce qu'ils travaillaient déjà avec de tels outils (hyper-calculateurs et modèles mathématiques sophistiqués) pour prévoir la météo des jours suivants ou saisonnière: il leur a donc été naturel d'utiliser la même méthode pour des prévisions beaucoup plus lointaines, sans tenir compte du fait que cet éloignement temporel peut changer radicalement la fiabilité de la méthode et sans vraiment réfléchir à d'autres méthodes. Pourtant ils devraient connaître mieux que quiconque les limites de la méthode qu'ils utilisent puisque déjà pour les prévisions saisonnières ( à trois mois), elle est incapable de dire autre chose que: "l'été sera certainement plus chaud (ou plus frais) que d'habitude". Et les décideurs politiques, même s'ils n'ont aucune connaissance en climatologie, feraient bien de réfléchir un peu par eux-mêmes au lieu de se laisser guider comme des ânes bâtés par des "spécialistes".

III- Interactions nuages-température du type "prédateurs- proies"

L'augmentation de la TMAM provoque une évaporation supplémentaire des sols et des océans d'eau qui s'élève sous forme de vapeur. La température de l'atmosphère baissant avec l'altitude et la saturation maximale en vapeur d'eau de l'air diminuant quand la température baisse, cette nouvelle vapeur formée par le réchauffement finit donc par se condenser quand elle monte. Elle s'agglomère donc aux nuages déjà présents ou, s'il n'y en a pas, en formera de nouveaux.

Sachant que la température diminue approximativement de 1°C par centaine de mètres d'altitude, la hauteur de saturation concerne les basses couches de l'atmosphère, c'est-à-dire la zone où se trouvent les nuages bas (altitude inférieure à 2000m). En effet, même si l'eau s'évapore à une température au sol de 35°C, à 2000 m la température n'est plus qu'à 15°C, température où l'air est très vite saturé en vapeur. Donc même dans ce cas, il y a une forte probabilité qu'elle se condense au niveau des basses couches et y reste sous forme de nuages bas. A plus forte raison si la température de l'air dans lequel elle s'évapore est inférieure.

Une part moindre peut se condenser plus haut, bénéficiant de phénomènes de convexion ascensionnelle et rejoindre les nuages de niveaux intermédiaires. Mais il nous semble nettement plus probable que cette vapeur se condense plus bas, pour les raisons déjà invoquées.

Il se peut aussi qu'une forte convexion entraine rapidement cette vapeur vers la stratosphère pour former des cumulonimbus, qui débouchent souvent sur des orages. Mais pour cela les conditions ambiantes doivent être assez particulières: d'après Météo-France, « les cumulonimbus dits de masse d'air, typiquement les orages en été de fin d'après-midi et qui sont relativement bénins, se forment à la suite de la convection causée par le réchauffement solaire de l'air près du sol, en l'absence de forçages dynamiques. La présence de forçages dus à la dynamique atmosphérique peut déstabiliser davantage l'atmosphère, ce qui augmente la probabilité de formation de cumulonimbus et la sévérité des orages qui en résultent. Ces derniers se développent en général à l'approche d'unfront froid ou par soulèvement orographique. La plupart des orages violents sont de ce type.»( pour plus de précisions, voir http://www.meteofrance.fr/publications/glossaire/150191-cumulonimbus)

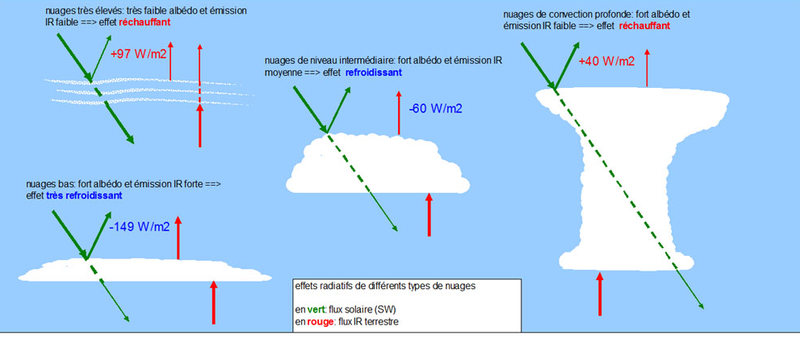

Donc en dehors de cette situation assez particulière débouchant souvent sur des orages, l'évaporation supplémentaire provoquée par le réchauffement nourrit au moins dans un premier temps surtout la couverture en nuages bas, en moindre partie la couverture intermédiaire. Or les nuages bas ont un fort effet de refroidissement et les nuages de niveau intermédiaire un léger effet de refroidissement, comme l'indique le schéma suivant issu de http://climat-evolution.eklablog.com/effets-radiatifs-des-nuages-1-a86578739

De plus, même si une part de l'évaporation se traduit par la formation de cumulonimbus à effet réchauffant, un autre phénomène neutralise cela:

« Les cumulo-nimbus ont tendance à se former en amas, là où se trouvent d'autres nuages. Dans les hautes couches de l'atmosphère, à 12 km d'altitude, cela entraîne une réduction des enclumes, des nuages hauts à effet de serre. Cela réduit au final cette couverture nuageuse et devrait mieux laisser s’échapper la chaleur (le rayonnement infra-rouge) vers l'espace, ce qui diminuerait la température. « C'est ce que l'on appelle l'effet d'iris , précise Sandrine Bony. Une hypothèse qui date des années 90 indiquait qu'ainsi la Terre régulerait l'augmentation de la température. En réalité, les études montrent que cela n'a qu’un faible impact et que les modèles ne manquaient déjà pas ce phénomène » ( https://reseauactionclimat.org/wp-content/uploads/2018/01/diminution-des-nuages-bas-aerosols-et-amplification-du-rechauffement-12-01-18-reseau-action-climat.pdf)

Cela justifie que notre modèle ne tiendra compte que de l'effet des nuages bas, les nuages intermédiaires n'ayant qu'un effet refroidissant faible, et l'effet d'iris annulant en grande partie l'effet réchauffant des nouveaux nuages hauts créés par l'évaporation supplémentaire provoquée par le réchauffement.

Par contre, notre modèle ne prendra en compte qu'une partie de cette évaporation pour le gonflement des nuages bas. Ceux-ci représentant 40% de la couverture nuageuse totale, nous prendrons cette valeur de 40% pour évaluer le pourcentage de vapeur supplémentaire provoquée par le réchauffement qui augmente la couverture nuageuse en nuages bas.

Dans tous les cas, suite à cette évaporation supplémentaire, il y a augmentation de la couverture en nuages bas, et cette augmentation refroidit l'air ambiant présent sous les nuages et fait donc baisser l'évaporation de surface. Il faut que ces nuages se dissolvent sous forme de précipitations ou qu'un nouveau réchauffement intervienne pour que le processus se réitère et conduise à la formation de nouveaux nuages bas.

Cela rappelle le comportement "prédateurs-proies" modélisant les variations respectives des populations de prédateurs et de proies dans une zone naturelle. Les nuages bas jouant le rôle des prédateurs (ils "mangent" la température), la température celui des proies:

Quand la température s'élève, c'est propice à la création de nuages bas; quand la couverture en nuages bas augmentent, cela baisse la température; quand la température baisse cela diminue la couverture en nuages bas; quand la couverture en nuages bas diminue, cela augmente la température, et ainsi de suite.

C'est l'un des deux phénomènes qui sera pris en compte de manière spécifique par notre modèle, le deuxième étant celui du "forcage radiatif d'origine humaine", essentiellement provoqué par les émissions de GES dont sont responsables les activités humaines. Comme déjà expliqué dans notre premier paragraphe, tout le reste sera pris en compte de manière moyennisée à partir des résultats de la TMAM telle qu'elle a été mesurée sur les cinquante dernières années.

IV- Prise en compte des émissions de GES et du forcage radiatif d'origine humaine

La grosse majorité des climatologues s'accordent pour penser que les émissions de CO₂ d'origine anthropique sont le principal facteur responsable du réchauffement climatique observé depuis les années 1970. Il est mesuré dans l'atmosphère en fraction de CO₂ dans l'air sec (µmol/mol notée aussi ppm pour "parties par million") et la courbe précédente donne son évolution depuis les années 1950 à Mauna Loa, l'un des volcans d'Hawaïe.

Quel est le rôle des autres GES ( méthane, gaz fluorés, etc...?) d'origine anthropique?

Le graphique suivant repris par le cinquième rapport du GIEC montre clairement que depuis au moins 1970 leur progression est similaire à celle du CO₂, même si leur part relative est nettement moindre. Il montre aussi que la somme des "forcages radiatifs d'origine humaine" suit depuis 1980 une courbe (la courbe en pointillés rouge) quasiment parallèle à celle des émissions de CO₂:

Aussi notre modèle confondra la progression des forcages radiatifs d'origine humaine avec celle des émissions de CO₂.

C'est bien sûr une approximation mais qui nous paraît largement suffisante pour nous permettre d'obtenir malgré tout des résultats de précision suffisante par rapport aux objectifs de notre modèle (simplicité et fiabilité).

Pour mesurer cette vitesse de progression des forcages radiatifs d'origine humaine, nous utiliserons donc la courbe donnée précédemment concernant les émissions de CO₂ à Mauna Loa.

Cette courbe est pratiquement rectiligne au moins pour la période qui nous intéresse, c'est-à-dire à partir de 1970 et jusqu'à nos jours. Jusqu'à 2020, la vitesse d'augmentation v de ppm par année est donc quasiment constante et donnée par le coefficient directeur très proche de 1,8 de cette quasi-droite: nous prendrons donc v = 1,8 ppm/an

Pour la période qui suit 2020, nous ferons la supposition que suite à la prise de conscience mondiale du problème du réchauffement climatique, cette augmentation ralentisse de a ppm par année à partir de 2020 et que cela fasse effet 10 ans après, durée d'inertie de l'effet réchauffant des émissions de CO₂. ( Cf. Katharine L Ricke and Ken Caldeira. Published 2 December 2014 • © 2014 IOP Publishing Ltd – http://iopscience.iop.org/article/10.1088/1748-9326/9/12/124002/meta).

V- Récapitulatif des hypothèses prises en compte par notre modèle:

- Géométrie de la Terre et de son atmosphère: La Terre sera assimilée à une boule sphérique entourée d'une atmosphère de 12 km d'épaisseur.

- Couverture nuageuse en nuages bas en 1970:

Nous l'estimons à environ 25% du ciel en 1970 puisqu'on sait que la couverture nuageuse mesurée pour la période 2004-2015 est d'environ 67% (d'après http://www.astronoo.com/fr/articles/couverture-nuageuse-mondiale.html) et que les nuages bas représentent environ 40% de la couverture nuageuse totale. Ce chiffre de 25% de nuages bas en 1970 n'a la prétention que d'être un ordre de grandeur suffisamment réaliste pour initialiser notre modèle.

- Hauteur moyenne des nuages bas en 1970:

Elle sera encore plus grossièrement estimée à 1500m, puisque les nuages sont considérés bas s'ils ne dépassent pas une altitude de 2000m environ.

- TMAM pour la période 1970-2019:

Pour l'obtenir, nous nous fondons sur le diagramme suivant issu du lien http://www.columbia.edu/~mhs119/Temperature/globalT_1880-1920base.pdf :

Plus précisément, nous utilisons sa courbe verte qui a été obtenue en lissant les températures moyennes sur 11 ans, durée d'un cycle solaire.

C'est elle qui va nous permettre de "caler" notre modèle pour ensuite pouvoir obtenir des prévisions fiables jusqu'à 2120.

On peut voir qu'il est mesuré pour les presque 50 ans de cette période 1970- 2019 une augmentation de 0,17°C par décennie puisque sur ces cinq décennies la TMAM passe approximativement de 14,15°C à 15°C.

- Augmentation annuelle de GES d'origine anthropique pour la période 1970-2020:

Compte-tenu de ce qui est indiqué dans le paragraphe IV, la progression des GES d'origine anthropique dans l'atmosphère est supposée constante de 1970 à 2020, ainsi répartie:

1,8 ppm/an pour le CO₂ et 0,9 ppm/an d'équivalent CO₂ pour les autres GES d'origine anthropique puisque la contribution du CO₂ est d'environ 2/3 de l'émission totale ( d'après https://jancovici.com/changement-climatique/gaz-a-effet-de-serre-et-cycle-du-carbone/quels-sont-les-gaz-a-effet-de-serre-quels-sont-leurs-contribution-a-leffet-de-serre/).

Soit donc au total et pour la période 1970-2020: une progression de 2,7 ppm par an de CO₂ ou d'équivalent CO₂.

- Inertie climatique des GES:

Toujours compte-tenu de ce qui est indiqué dans le paragraphe IV, pour notre modèle, toute modification de concentration des GES dans l'atmosphère n'agira sensiblement sur la TMAM que dix années après.

VI - Mise en place de notre modèle:

- Notations:

- n est le nombre d'années après 1969, année 0 de notre étude.

- cn correspond à l'augmentation de ppm de CO₂ ou d' équivalent CO₂ pour l'année n,

- a: la diminution de l'augmentation de ppm par an, supposée nulle avant 2020 et constante positive à partir de 2020

- tn: température moyenne l'année n après 1970 en tenant compte du phénomène "prédateurs-proies" qu'il y a entre les nuages bas et la température tel qu'il est précisé dans le paragraphe III..

- en: la couverture nuageuse en nuages bas l'année n exprimée en pourcentage du ciel

- hn: la hauteur moyenne des nuages bas l'année n exprimée en km..

- Couplage des suites en jeu pour la période 1970- 2020:

Pour n entier compris entre 1 et 50 où cn et constante et égale à 2,7 et a=0, nous avons:

(1) <=> t(n+1)=t(n)+K-k(e(n+1)-e(n)) pour n>2 avec t(1)=14,15°C et t(2)=t(1)+K

(2) <=> e(n+1)=e(n)+k'(t(n)-t(n-1)) pour n>2 avec e(1)=e(2)=25%

(3) <=> h(n+1) = h(n) + 0,1 (t(n+1)-t(n)) avec h(1)=1,5 km

- Estimations des constantes k, k' et K:

La constante k qui intervient dans la relation (1) correspond au lien supposé linéaire entre l'augmentation de la couverture de nuages bas et la baisse de température que cette augmentation provoque.

Vu les hypothèses très simplificatrices que nous adoptons, un simple ordre de grandeur de k suffira.

Pour l'obtenir, nous partirons du résultat suivant, donné par le physicien et climatologue Yves Foucart dans https://www.futura-sciences.com/planete/dossiers/climatologie-tant-incertitudes-previsions-climatiques-638/page/4/:

« Les mesures du bilan radiatif effectuées depuis satellite ont permis d'évaluer l'effet d'albédo et l'effet de serre des nuages existants. On a ainsi déterminé le forcage radiatif des nuages : c'est, par définition et au signe près, la variation du bilan radiatif de la Terre qui résulterait d'une disparition pure et simple de tous les nuages. Il comporte une composante courtes longueurs d'onde et une composante grandes longueurs d'ondes infrarouge. La première est négative car les nuages diminuent l'énergie absorbée, la deuxième est positive puisqu'elle traduit un effet de serre. Les deux termes sont très grands: en moyenne annuelle, environ - 47 Wm-2 pour l'effet d'albédo et +29 Wm-2 pour l'effet de serre. Globalement donc, l'effet d'albédo l'emporte et l'effet résultant des nuages est de refroidir la planète. Si, instantanément, ils devenaient transparents, le bilan radiatif augmenterait de 18 Wm-2 .»

Or une augmentation de 4 Wm-2 provoque un réchauffement à la surface d'environ 1°C. (d'après http://planet-terre.ens-lyon.fr/article/effet-de-serre-royer.xml). Donc une augmentation de 18 W/m² entraine un réchauffement au sol d'environ 4,5°C.

Donc 1% de nuages bas en plus ou en moins entraine 4,5/25= 0,18°C de température en plus ou en moins. Donc on prendra k=0,18 et la relation (1) s'écrit donc:

(1) <=> t(n+1)=t(n)+K-0,18(e(n+1)-e(n))

Pour obtenir la constante k' qui intervient dans (2), nous faisons l'hypothèse assez logique que l'évaporation supplémentaire provoquée par le réchauffement impacte directement et linéairement la couverture nuageuse de l'atmosphère en nuages.

Or l'évaporation augmente avec le réchauffement de 2% par degré au-dessus des océans d'après https://reseauactionclimat.org/wp-content/uploads/2018/01/diminution-des-nuages-bas-aerosols-et-amplification-du-rechauffement-12-01-18-reseau-action-climat.pdf.

Puisque les nuages bas composent approximativement 40% de la couverture nuageuse totale, 1°C en plus crée 0,4 X 2 = 0,8% supplémentaire de couverture nuageuse en nuages bas, donc k'=0,8 et la relation (2) s'écrit finalement:

(2) <=> e(n+1)=e(n)+0,8(t(n)-t(n-1))

Enfin, pour obtenir K, nous "calons" le système (1) et (2) pour qu'il donne en 2020 une température d'environ 15°C, TMAM mesurée à cette date. Nous obtenons K=0,02.

Comment peut-on interpréter cette valeur de K? S'il n'y avait pas l'effet rétroactif négatif des nuages bas de type "prédateurs proies" tel que nous l'avons précisé au paragraphe III, la TMAM aurait augmenté de 0,2°C (au lieu de 0,17°C dans la réalité) par décennie entre 1970 et 2019 et aurait donc atteint la valeur de 15,15°C au lieu de 15°C en 2019.

Donc pour la période connue de 1970 à fin 2019, notre modèle est donné par le système suivant:

VII - Modèle finalisé pour la période 1970-2120:

Fondé sur la période connue 1970-2020 et en tenant compte de tout ce qui a été précisé notamment sur l'évolution des émissions cn de GES en ppm de CO₂ ou d' équivalent CO₂, notre modèle discret pour la période 1970- 2120 se traduit par le système suivant:

VIII - Prévisions de notre modèle pour différentes valeurs de a:

Rappelons d'abord que a représente la diminution de l'augmentation de ppm par an, supposée nulle avant 2020 et constante positive à partir de 2020.

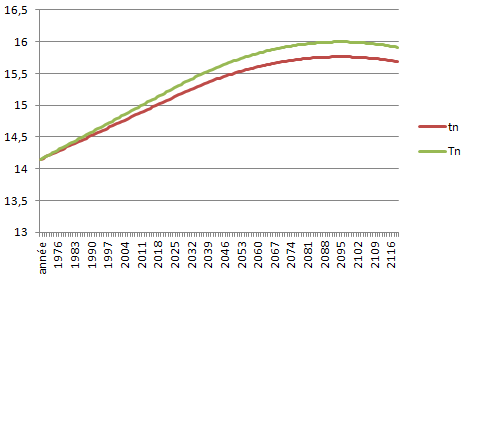

Les graphiques qui suivent donnent pour plusieurs valeurs de a l'évolution de la TMAM tn pour la période 1970-2120. Pour les obtenir, nous avons programmé sur tableur le modèle discret présenté au paragraphe précédent. Nous avons aussi représenté la courbe de Tn, la TMAM qu'il y aurait s'il n'y avait pas l'effet retro-actif et régulateur des nuages bas. Voici le fichier qui a permis de générer ces courbes: Mod_le_TMAM_Zeltz_e

Evolution de la TMAM pour a=0 (aucune modification à partir de 2020 concernant la progression des émissions d'origine anthropique des GES mesurées et moyennisées pour la période 1970-2019):

TMAM prévue dans cette hypothèse en 2120: environ 16,8°C

Evolution de la TMAM pour a=0,02 (A partir de 2020, l'augmentation cn de ppm par an diminue de 0,02 ppm par année)

TMAM dans cette hypothèse en 2120: environ 16,2°C

Evolution de la TMAM pour a=0,04 (A partir de 2020, l'augmentation cn de ppm par an diminue de 0,04 ppm par année)

TMAM prévue dans cette hypothèse en 2120: environ 15,7°C

Evolution de la TMAM pour a=0,08 (A partir de 2020, l'augmentation cn de ppm par an diminue de 0,08 ppm par année) prévue dans cette hypothèse en 2120: environ 14,6°C avec un maximum de 15,5°C atteint vers 2060.

IX - Discussion et conclusion:

Quelques remarques:

Nous remarquons que l'effet retro-actif des nuages bas sur la TMAM, s'il n'est pas énorme (au plus quelques dixièmes de °C en moins de tn par rapport à Tn) est réel, et qu'il s'accentue avec l'augmentation de la TMAM.

Nous remarquons aussi qu'une décroissance lente (0,08 ppm en moins de progression chaque année) permet de retrouver en 2120 une TMAM inférieure à l'actuelle. Cela dit, il faudrait évaluer concrètement cette baisse et les efforts qu'elle représente pour l'humanité, ce que nous n'avons pas fait. En tous les cas, cela paraît être un objectif souhaitable et réalisable pour les décennies futures.

Robustesse du modèle:

Comme nous l'avons vu, certaines constantes ou valeurs initiales utilisées ne sont que des ordres de grandeur assez grossiers, avec une grosse part d'imprécision, sans doute dans une fourchette large de + ou - 5%. Il s'agit notamment:

- de la couverture initiale en nuages bas fixée à 25%,

- de la hauteur moyenne des nuages bas fixée à 1,5 km,

- de l'augmentation moyenne sur les 50 premières années fixée à 2,7 de la quantité de ppm de CO₂ ou équivalent CO₂ présents dans l'atmosphère ,

- des valeurs des constantes k et k' présentes dans le système.

Aussi nous avons pris le soin de tester le modèle pour d'autres valeurs dans cette fourchette de + ou - 5%. Nous avons pu constater que le comportement global de la TMAM reste inchangé, et que les valeurs finales obtenues pour la TMAM en 2120 reste dans une fourchette beaucoup plus serrée (+ ou - 2%). En ce sens, notre modèle peut-être considéré comme très robuste.

Simplicité du modèle:

Notre modèle est simple à double-titre: d'abord pour son paramétrage, ensuite par sa vitesse d'éxécution, inférieure au millième de seconde à partir d'un simple micro-ordinateur. C'est tout le contraire pour les modèles utilisés par le GIEC: extrême complexité du paramétrage et des journées de travail d'hypercalculateurs sont nécessaires pour obtenir les résultats. Tout cela pour arriver à des résultats fort différents d'un modèle à un autre.

Fiabilité du modèle:

Contrairement à ceux validés par le GIEC, notre modèle n'a pas pour base théorique des systèmes mathématiques fortement non linéaires, à effets chaotiques, mais repose essentiellement sur une moyennisation de ce qui a été observé sur les cinquante dernières années. Cette assise est suffisamment longue et complète pour qu'elle permette un prolongement quasi-linéaire sur les décennies qui suivent, cela en ne modifiant qu'un paramètre: la valeur de a. Donc une fiabilité théorique certaine au départ, contrairement aux modèles mis au point par les climatologues travaillant pour le GIEC.

Cela dit, ce modèle ne sera vraiment validé que dans quelques décennies, en comparaison de la réalité observée avec ce qu'il prévoit. Mais ceci est le lot de n'importe quel modèle prédictif.

En conclusion, et jusqu'à preuve du contraire, ce modèle répond à tous nos objectifs initiaux: simplicité, robustesse et fiabilité pour l'obtention de la TMAM dans les cent ans qui viennent.

/https%3A%2F%2Fassets.over-blog.com%2Ft%2Fcedistic%2Fcamera.png)

/https%3A%2F%2Fstorage.canalblog.com%2F29%2F57%2F1659190%2F124117069_o.png)

/https%3A%2F%2Fstorage.canalblog.com%2F80%2F36%2F1659190%2F124041499_o.png)

/https%3A%2F%2Fstorage.canalblog.com%2F20%2F60%2F1659190%2F124041156_o.png)